当数据具有巨大商业价值却又无法明确其权属,爬虫战争就会永无休止。本文来自微信公众号:财经E法(ID:CAIJINGELAW),作者:殷继、姚佳莹,编辑:朱弢,原文标题:《互联网“虫患”难除》,题图来自:视觉中国

爬虫几乎伴随着整个互联网的发展,作为一项计算机技术,它能自动且高效地浏览互联网完成“复制、抓取”两个动作。如果完全封禁网络爬虫,可能导致互联网发展“寸步难行”;但倘若不设置任何“屏障”,又可能导致互联网沦为“数字丛林”。

法律难以确定一项“既要...又要...”的规则来划定爬虫合法界限。robots协议作为国际互联网通行道德规范,但却常常被网络恶意访问者所无视,有的网络爬虫行为直接侵害他人权益,有的网络爬虫行为直接涉嫌犯罪,更多的网络爬虫行为处于法律灰色地带之中,围绕着“爬虫”与“反爬虫”成为了互联网世界中的“永无休止战”,目的都是:获得数据。

当数据权属悬而未决,也就注定了网络爬虫战争难以落幕。

1. 爬虫经过之地,“乐园”还是“焦土”?

网络爬虫是一种“自动浏览万维网”的网络机器人,它作为一项计算机技术,自动且高效地浏览互联网并完成“复制、抓取”两个动作。“爬虫”二字在中文语境带有“贬义”,不免让人联系成为一类有害之物,必须加以消灭。

但实际上,网络爬虫是项中立的技术,合理合法地使用,它可以如同蜜蜂扩散传播花粉般,在互联网上充当着信息自由交换的工具;但如有使用者心怀叵测,它也可以掀起一场“蝗灾”,让网站、App瞬间崩溃,或是侵犯个人隐私。

爬虫技术最常见运用在搜索引擎中,爬虫可以将自己所访问的页面数据保存下来,制作成为索引以便供用户搜索网页。通常而言,搜索引擎爬虫是网站经营者乐于接受的,爬虫访问会提升网站的曝光率。但有些时候,爬虫并不“受人欢迎”。

2019年,国内外不少网站经营者抱怨遭遇了一些搜索引擎爬虫的访问,因访问频率过高,一度令一些网站瘫痪。“短短一上午时间就收到了 46 万次请求,消耗掉服务器 7.42GB 流量。这对平均日活可能都没有过千的小网站来说,已经算得上一次小型的DDoS攻击。”一位遭遇搜索引擎爬虫的网站经营者对此感叹道。

(DDos攻击:指通过大规模互联网流量淹没目标服务器或其周边基础设施,以破坏目标服务器、服务或网络正常流量的恶意行为。 )

“通常爬虫会定位网站所有的URL链接,获取页面里的数据,再对数据进行拆解利用。无论是在网页端还是移动端,爬虫都基于这样的原理。”欧莱雅中国区数字化负责人刘煜晨介绍。“对于那些小网站或者技术实力弱的网站,如果被爬虫7x24小时持续的大量访问,可能因服务器无法承受导致网站崩溃。”

在现实生活中,其实很多人都与爬虫“打过交道”。比如,逢年过节之时,为确保能买到回家火车票,有人会选择使用“抢票软件”,这个软件就是利用网络爬虫来登录铁路售票网络,并爬取票务信息,然后辅以批量化、自动化和高速化的购票流程处理,从而能以毫秒级的刷新来获取人工购票难以企及的信息和速度优势。显然,这种“充钱加塞”的方式显然对正常渠道的购票者有失公平。

就连最高人民法院旗下的“中国裁判文书网”也难逃爬虫侵扰,以至于用户怨声载道。2019年,最高人民法院发布的《关于“中国裁判文书网”网站建设建议的答复》提到,“大量技术公司通过爬虫系统无限制地访问非法获取裁判文书数据,造成网站负荷过大,大量正常用户请求堵塞,访问出现速度慢或部分页面无法显示等现象。”

网络爬虫不光消耗“被爬取方”网站的流量,同时能够“抓走”网站页面的数据,因此常引发纷争。

2016年,百度因大量使用爬虫抓取大众点评的点评信息,在百度地图中进行展示,后被大众点评诉至法院。法院审理认为,百度的行为违反了公认的商业道德和诚实信用原则,构成不正当竞争。

▲ 大众点评诉百度不正当竞争案,百度被判赔323万元

对编写网络爬虫的程序员来说,如果爬到不该爬取的数据,则存在违法的可能。程序员圈内对此戏称,“爬虫写得好,牢饭吃得早”。从裁判文书网的检索结果来看,利用网络爬虫作为犯罪工具涉及的主要罪名有:侵犯公民个人信息罪、非法获取计算机信息系统罪、破坏计算机信息系统罪、传播淫秽物品牟利罪、侵犯知识产权罪、诈骗罪等罪名。目前,能够检索到50余件相关判例。

2. robots协议,一扇虚掩着的门

谈论网络爬虫,就不可避免地谈及robots协议,它好比你悬挂在酒店房门口“请勿打扰”或者“请即打扫”告示牌,旨在通过代码来沟通“爬取方”和“被爬取方”之间的“爬取意愿”。

1994年,荷兰工程师傅马丁·科斯特(Martijn Koster)起草了robots协议,而起草这份协议的初衷,正是由于马丁·科斯特自建的网站经常被爬虫所淹没。马丁·科斯特认为,被爬虫抓取数据这件事是把双刃剑,良好的爬取可以提高网站的曝光率,而恶意的爬取可能会导致服务器压力暴增而导致崩溃。

robots协议写法,例如:禁止Google爬虫

User-agent: Googlebot

Disallow: /

马丁·科斯特起草的robots协议后来成为互联网世界通行的道德规范,但这份协议更像是一份“君子协议”。马丁·科斯特声称,该协议既不是强制性标准,没有任何强制执行力,仅是一项技术措施,违反它只能放在商业道德的范畴来评价。

2012年11月1日,由中国互联网协会牵头,robots协议写入了由12家中国互联网企业签署了《互联网搜索引擎服务自律公约》中,此后成为多起“网络爬虫”相关诉讼案件法院裁判所参考的规则。

遵循国际通行的行业惯例与商业规则,遵守机器人协议(robots协议)。

——《互联网搜索引擎服务自律公约》第七条第1款

互联网所有者设置机器人协议(robots协议)应遵循公平、开放和促进信息自由流动的原则,限制搜索引擎抓取应有行业公认合理的正当理由,不利用机器人协议进行不正当竞争行为,积极营造鼓励创新、公平公正的良性竞争环境。

——《互联网搜索引擎服务自律公约》第八条

而robots协议被更多人所知晓,起因于2013年的“360诉百度不正当竞争案”。该案原告奇虎公司指出,2012年8月16日,奇虎公司上线运营“360搜索引擎”,但百度并未在相关网站的robots协议中将“360搜索引擎”列入其“白名单”。故奇虎指控百度的行为构成不正当竞争,将其诉至法院,之后百度败诉。

可能是为了让人们更好地理解相关的原理,法院在一审判决中作出了形象的解释,“robots协议就相当于在博物馆入口处悬挂的提示牌,告知游客哪些区域不对外开放,提示牌的目的并不是限制游客的正常参观活动,而是通过提示游客哪些区域为非参观区,从而引导游客更有效的参观游览。提示牌的内容对所有游客应一视同仁,如果要禁止某一类人进入参观,则需要有合理、正当的理由。”

百度后来提起上诉认为,搜索引擎遵循robots协议就是遵守行业惯例和公认的商业道德。robots协议体现了网站与搜索引擎之间的交易自由,而一审判决以“促进信息共享”为由限制互联网内容提供者自由选择交易对象,若要求设置robots协议限制通用搜索引擎抓取应当具有的合理正当理由,实质上将废止robots协议。

上诉案件经过长达近六年的审理,二审法院于2020年7月做出维持原判的决定。二审法院认为,“百度在缺乏合理、正当理由的情况下,以对网络搜索引擎经营主体区别对待的方式,故构成反不正当竞争法第二条规定所指的不正当竞争行为。”

经营者在生产经营活动中,应当遵循自愿、平等、公平、诚信的原则,遵守法律和商业道德。

——《反不正当竞争法》第二条

尽管是一项通行规则,但robots协议仅是一道“虚掩着的门”,无法在实质上限制爬虫。

“robots协议只是文字宣示,不是技术措施,客观上无法阻止网络机器人抓取网络数据。”在北京微梦创科网络技术有限公司(下称“微梦创科”)与北京字节跳动科技有限公司(下称“字节跳动”)不正当竞争纠纷中,一审被告新浪微博所属的微梦创科在上诉状中如此表示。

在该案中,一审原告字节跳动认为新浪微博将其添加至robots协议的“黑名单”无合理理由,违反了相关法律规定和行业公认的商业道德,构成不正当竞争,诉请法院判令微梦创科停止不正当竞争行为、刊登道歉声明、赔偿其经济损失1亿元及制止侵权的50万元支出。

2017年,微梦创科一审败诉,北京市知识产权法院支持字节跳动停止不正当竞争、刊登道歉声明的请求,酌定微梦创科向字节跳动赔偿经济损失30万元及制止侵权的34343元支出。

北京市知识产权法院的主张与“360诉百度不正当竞争案”相似。“本质上按照经营主体来区分网络信息是否可以被抓取,.......此种针对性的限制措施显然与行业公认的robots协议公平、开放和促进信息自由流动原则不符,与互联网行业普遍遵从的开放、平等、分享、协作的互联网精神相悖,不利于维护公平参与、理性竞争的互联网市场竞争环境。”

四年后,北京市高级人民法院对该案作出二审判决,撤销一审判决,并驳回了字节跳动所有诉讼请求。法院认为,“robots协议在某种意义上已经成为维系企业核心竞争力,维系市场有序竞争的一种手段。尽管robots协议客观上可能造成对某个或某些经营者的“歧视”,但在不损害消费者利益、不损害公共利益、不损害竞争秩序的情况下,应当允许网站经营者通过robots协议对其他网络机器人的抓取进行限制,这是网站经营者经营自主权的一种体现。”

“技术是中立的,但技术应用永远不是中立的。”新浪集团诉讼总监张喆对此表示,“评价爬虫技术原理没有意义,更重要的是爬虫技术用来干什么,看它的行为本身是否具有正当性。”

设置robots协议像是一道“虚掩着的门”,尽管协议用文字向爬虫宣告“是否接受爬取”以及“可以爬取的范围”,但它本质上并不能阻拦爬虫访问。设置robots协议的行为在全球各地的司法裁判中也得到不同的评价。

2017年,在HiQ诉领英案中,HiQ公司对领英网站实施了网络爬虫,但加利福尼亚北区地区法院的法官认为,这种爬虫行为并不违反法律,因为领英网站上的数据是公开数据,对于公开数据,即使违反对方设置的robots协议,也应当是被法律允许的。

法官认为,爬虫行为就像在白天推开一家未锁门的商店进去看看,并不能将其认定为非法侵入。法院最后不仅没有认定 HiQ公司的爬虫行为违法,甚至反过来认定领英的反爬虫技术违法,要求领英公司移除针对HiQ的接入壁垒。但目前,该案由美国最高法院发回至旧金山第九巡回上诉法院重审。

早年间,以爬虫技术访问他人网站内容,视为对于他人财产权的侵犯。1992年,eBay诉Bidder's Edge(一家提供拍卖信息的网站)案中,eBay指控Bidder's Edge未经许可复制了eBay网站的内容,eBay已通过robots协议进行限制,但Bidder's Edge并未遵守。审理此案的法官指出,eBay的服务器是私有财产,eBay授予公众可以有条件的访问,并禁止包括Bidder's Edge在内所采取的自动化式的访问。

审理此案法官认为,超出同意的范围,就构成对他人财产的侵犯;而Bidder's Edge的行为明显超越了eBay允许的使用范围,构成非授权的使用,是对eBay财产的侵犯。法官认可robots协议既是权利人保护私有财产的一种正当技术手段,设置robots协议为免受爬虫骚扰性访问的通行做法。

如被抓取的数据涉及侵犯知识产权,是否设置robots协议则还成为授权许可与否的判断,而这点各国采取的判断标准则完全不一。

在2006年,美国的Field诉Google案中,原告布雷克·菲尔德(Blake Field)向法院起诉Google从自建网站中抓取作品侵害其享有的著作权。但Google辩称,原告未在其网站中设置robots协议,即为默示许可Google的抓取行为。法院支持了Google的观点,未设置robots协议的做法视为其默许搜索引擎抓取,Google并未侵权。

在2017年,比利时法院与美国法院的观点截然相反。在Copiepresse诉Google案中,原告Copiepresse作为一家比利时的报业集团,因Google利用搜索引擎抓取原告网站中享有著作权的内容,故诉至法院。

Google辩称原告Copiepresse可以设置robots协议的方式来告知搜索引擎的网络机器人可以抓取的范围,但原告却没有这么做,说明原告对于抓取是默示许可的。最终,比利时法院认为,著作权属于排他性权利,没有使用robots协议并不代表默示许可,最终支持了原告的主张。

3. 无休止之战:爬虫与反爬虫

“现在各行各业都需要用到爬虫技术,大到政府部门,小到个体商户、科研人员,要发展大数据产业,这些数据可能通过各种爬虫技术来获取,再进行数据清洗、整理、收集、入库,调用。”互联网爬虫技术从业者的支先生对《财经》E法表示道。“数据分布在互联网各个角落,爬虫可以将其采集出来,利用数据产生价值。”

支先生认为,有的平台型企业在初创期可能允许爬虫爬取数据,帮助其推广和宣传,但发展具有一定规模后,它们会认为数据已形成独特的竞争力,从而倾向于保护数据,限制爬虫爬取。“在国内,涉及大型平台之间的数据爬取时,大多以不正当竞争为由发起诉讼。”

爬虫与反爬虫之间成为一场无休止之战,发起攻击的一方需要思考如何“锋利其矛”,而防守一方则需要考虑如何“牢固其盾”。

“各个公司负责反爬虫设计的人,一定也是爬虫高手。”支先生说,最为常见的反爬取手段是限制IP或者限制ID账号,在发现账号有异常访问的情况时,就对其进行阻拦。“但没有绝对稳固的城墙,只有相对的安全,如果说一家反爬取能力已经达到80%了,哪怕在上面再往上提高1%,可能又要投入上千万元,甚至上亿元,没有任何意义。”

最为常见的是,通过“验证码”进行身份验证,像拖动图形滑动验证、数学计算、图形识别、手机验证码等方式,但都各有局限。“像手机验证码。这种防线其实也能被突破,现在有很多供应商提供自动验证服务,花费大概是每条1分线。”另一位不愿具名的爬虫从业者表示,“爬虫从技术角度根本防不住。”

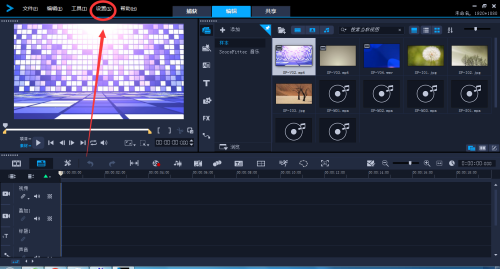

谷歌作为站在爬虫技术顶端的公司,在2009年收购由卡内基梅隆大学研发reCAPTCHA人机验证机制,并运用于反爬虫领域,如发现可疑访问者,需要完成识别后才可以继续访问网站。十多年间,reCAPTCHA人机验证机制也在不断升级,来对抗企图破解绕过验证机制的爬虫。

▲ reCAPTCHA人机验证机制

从技术上看,这是一场“道高一尺,魔高一丈”的战争,但现实出发,爬取数据的一方也并不总是处于主动地位。对于爬虫从业者来说,他们很难明确分辨自己的行为是否违法,以及是否会遭到惩罚。有时候他们能“置身事外”,引发的争议仅发展为平台之间的“不正当竞争”民事诉讼,但有的时候他们则可能沦为犯罪行为中的“共犯”。

“对于我们这些从业者来说,爬虫涉及到的法律风险难以把握,很多大公司里岗位职责分明,技术人员可能觉得自个就是一个写代码的,稀里糊涂就被抓了。”支先生对此表示道。“不管民事侵权还是犯罪行为,问题背后的根源还是数据的权属不明晰。”

倘若将“爬取数据”与“入室盗窃”比较,入室行为侵犯了他人私人自治空间,而盗窃行为侵犯他人财产权;但“爬取数据”本身行为部分却往往发生于原本开放的网络环境之中,当“数据权属”未明晰时,则很难确定“谁因此受到损害”、“谁将遭受到惩罚”以及“谁有权能获得赔偿”。

4. 爬虫抓取的数据属于谁?

爬虫爬取的数据应属于个人还是平台?

在微梦创科与字节跳动不正当竞争纠纷案中,今日头条认为,数据应属用户所有,微博并不具备对用户数据的任何权利,因此只要爬虫是在用户授权的情形下进行的,那么即使头条违反了微博的robots协议,也不违法。

但微梦创科认为,数据应属于平台所有,因为在用户协议中已作出约定:“用户同意不可撤销地授权微博平台作为微博内容的独家发布平台,用户所发表的微博内容仅在微博平台上予以独家展示。”

还有一种观点认为,数据属于个人与平台共有。在新浪诉脉脉不正当竞争案中,法院认为,数据开放的前提需遵循“用户授权+平台授权+用户授权”的“三重授权”模式,即平台首先取得用户同意而收集数据,在平台向第三方授权使用此类信息时,第三方还应当明确告知用户其使用的目的、方式和范围,再次取得用户的同意。

这一判决理由意味着,个人和平台对于数据都拥有一定的权利主张,数据在一定程度上为个人与平台所共有。

也有观点认为,互联网具有公共属性。加利福尼亚大学伯克利法学院教授奥林·科尔(Orin Kerr)有过经典描述,在他看来,互联网的一般原则是开放性,这种开放性允许世界上任何人发布信息或数据,数据可以被任何人访问,而无需进行身份验证。当然,奥林·科尔的观点并不受企业欢迎,这些企业往往认为通过经营活动吸引用户积累数据,对整体数据资源享有竞争性利益。

“不谈论数据合法生产者具有控制权,难以对爬虫合法性进行判断。”华东政法大学法律学院教授、数据法律研究中心主任高富平认为,现在国内的判决,基本在竞争法的框架下进行裁判,即爬虫目的是否“实质性替代”被爬一方的业务,成为判断爬虫合法性的关键,有损害后果才制止爬虫行为,总是有它的局限性。

“如果承认数据生产者具有数据的控制权,基于控制权,就可以对于那些无视robots协议的数据爬取者进行打击。”高富平表示道,“更重要的是承认数据合法生产者可基于商业目的来开放数据,以许可使用方式或者其他交换交易等方式,让数据为更多人所使用。”

从国内立法来看,2021年6月颁布的《深圳经济特区数据条例》首次以立法形式提及了“数据财产权”的概念,其中第四条作出规定,认可自然人、法人和非法人组织对其合法处理数据形成的数据产品和服务享有法律、行政法规及本条例规定的财产权益。高富平在接受媒体时表示,《深圳经济特区数据条例》将数据财产权分配给自然人、法人和非法人组织是存在冲突的。

“个人的数据权应该保护的是个人的尊严和自由,基本上属于人格权范畴,而不是一个财产权,如果把个人的数据权定有财产权属性,那个人在决定数据使用的时候,他的决定权就会和国家、企业的相冲突,这里面就会有权利“打架”的问题,无法构建数据的利用秩序。”高富平对此评价。

爬虫抓取的数据属于谁?中国人民大学法学院副教授丁晓东则认为,爬取平台数据而引发的数据此,无论把平台数据权属归于哪一方都不合理。有的场景下,属于个人数据范畴,需要数据隐私法的优先保护;有的场景下,平台数据具有类似数据库的性质,需要“类似数据库权益”的保护;而在其他场景下,平台数据又具有公共性,需要法律保障数据的共享与流通。

假如可能封禁所有网络爬虫的话,互联网可能将会“寸步难行”;倘若又未对爬虫设置任何“屏障”,互联网则可能沦为“数字丛林”,最终侵害到用户权益。因此,该如何规制网络爬虫行为,让互联网既保持自由、开放,又能有序健康发展,成为互联网行业都面临挑战。

当数据权属仍悬而未决时,也就意味着从未无休止爬虫战争仍将继续。

本文来自微信公众号:财经E法(ID:CAIJINGELAW),作者:殷继、姚佳莹,编辑:朱弢